Responsabilidad social en plataformas OTT

Prevención del suicidio, bullying y depresión en la web, como foco central de la regulación en redes sociales y servicios online.

El contagio social de prácticas dañinas puede resultar fatal para adolescentes y adultos. Las autolesiones, restricciones alimenticias, bullying y otros, se transmiten viralmente en Internet. Por ello, es necesario que las plataformas OTT tomen medidas de acción directa.

Los padres de la adolescente Molly Russell, quien tenía 14 años cuando se suicidó en Reino Unido el 2017, reactivaron el debate por la responsabilidad social de los intermediarios de contenido en la web. Sus padres, tras acceder a su plataforma Instagram, se encontraron con cientos de imágenes y cuentas que promovían el suicidio, todas bajo el hashtag #selfharm.

Normas de contenido

La discusión sobre los contenidos que se difunden en la web, independiente de su origen – red social, imageboard, correos, etc – ha estado siempre presente. Algunos países y plataformas, poseen normativas regulatorias en torno a los contenidos permitidos. El punto es ¿son realmente contenidos regulados?

El conflicto entre la neutralidad de la red, y el control normativo en cuanto a contenidos sensibles, es complejo. Sobre todo para menores de edad que están en permanente relación con la web y pueden acceder a una amplia gama de información con sólo un clic. Las temáticas altamente sensibles, pueden presentarse de variadas formas, sin necesidad de acceder a la deep web .

Tanto redes sociales como otro tipo de plataformas, señalan en sus políticas de contenidos y normas comunitarias, que todo contenido que llame a atentar contra la vida o sea ilegal, está prohibido. La pregunta es ¿Cómo se sanciona a quien no cumple la norma, y quién lo controla efectivamente?

Responsabilidad de los prestadores de servicios

El 2018, Reino Unido anunció modificaciones a la ley referidas a la protección de menores, que otorgará mayor responsabilidad a las redes sociales. El plan, lanzado en mayo de 2018, se suma a la petición de organizaciones contra el bullying y el suicidio adolescente, para hacer a las redes sociales seguras.

En Chile, una investigación de la fundación Derechos Digitales, reveló que las políticas públicas sobre responsabilidad en prestadores de servicio, suelen ir enfocadas a la pornografía e ilegalidad comercial de ciertos actos, por lo tanto, son insuficientes considerando el panorama global. Sin embargo, la mayoría de los países estudian la creación de nuevas normativas, capaces de asumir los desafíos de una Internet que avanza y manifiesta nuevas problemáticas.

“Instagram ayudó a matar a mi hija”

Los padres de Molly Russell, consideran que Instagram fue cómplice de su muerte. La niña de 14 años, que se suicidó en 2017, seguía contenidos bajo el hashtag #selfharm que no sólo mostraban autolesiones y sangre, también promovían ser “valiente” y suicidarse.

La entrevista de la BBC en que el padre de Molly señala esta co-responsabilidad de parte de Instagram, desencadenó una serie de hechos que contribuyeron a eliminar las imágenes de autolesiones de su búsqueda y feed. Tras una reunión entre el Secretario de Salud de U.K., Matt Hancock, y el nuevo Head de Instagram, Adam Mosseri, se anunciaron cambios en su política de contenidos, con especial énfasis en imágenes de autolesiones.

Sin embargo, la brecha entre lo permitido y censurado se mantiene presente. Bajo la premisa de que no todas las personas que se autoinflingen lesiones, tienen intención de suicidarse (como quienes poseen desórdenes alimenticios), Instagram mantendrá el hashtag con historias de superación de la depresión, y comunidades que incentiven el autocuidado, “sin dejar de ayudar a quienes piden ayuda”.

¿Necesitas ayuda?

El famoso imageboard Tumblr, ha tenido que reformular recientemente su algoritmo para dejar fuera la pornografía de la plataforma. Estableciendo una censura inmediata a contenidos denunciados como inapropiados por los usuarios, fue cuestionada por su normativa de censura.

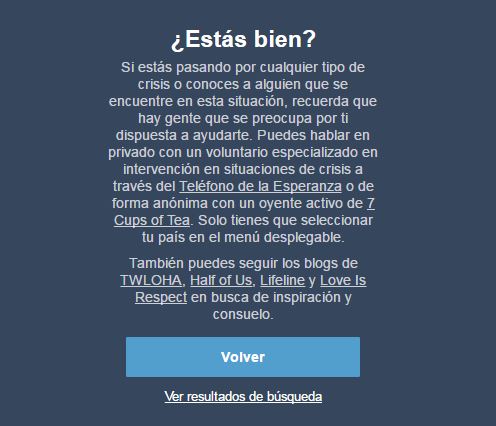

Esta red, también fue una de las primeras plataformas en implementar una interfaz “preventiva” para la depresión y suicidios, ya que poseía una gran cantidad de contenido referido a éstas temáticas, totalmente disponible, y subido por los propios usuarios.

Otro caso, se presenta en la serie original de Netflix, “13 reason why”, que también fue acusada de incentivar el suicidio. Debido a que su transmisión es hecha a través de un servicio OTT, Netflix vinculó la plataforma web de la serie, a organizaciones de prevención del suicidio, además de agregar un mensaje de prevención de la violencia y depresión en el opening de cada uno de sus capítulos. Sin embargo, expertos señalan que este sistema de sugerencias, no es suficiente para ayudar a quienes lo necesitan.

Tal como se analiza en la BBC, los algoritmos (en cualquier plataforma que funcionen), están programados para mostrarnos más contenido relacionado con el que interactuamos. En ese sentido, podrían ser fatal para polarizar emociones y mostrar constantemente publicaciones no supervisadas, que quebrantan las normas comunitarias.

No es suficiente decir que el contenido no existe, es necesario asegurarse de que no está disponible. Por ello, tanto la ley como las plataformas, deben seguir trabajando en pos de un Internet más seguro.

Acerca del Autor

Agregar un comentario